Dries Dury, DPAM: „Während die derzeitigen KI-Anwendungen bereits sehr beeindruckend sind, gehen wir davon aus, dass der rasche Fortschritt der KI zu erstaunlichen bahnbrechenden Technologien und enormer wirtschaftlicher Wertschöpfung führen wird.“

Welche Faktoren bestimmen die Leistungsfähigkeit eines KI Modells?

Wenn man sich auf den Gedanken einlässt, dass sich ein künstliches Neuron nicht grundlegend von seinem biologischen Gegenstück unterscheidet, könnte man sich ein künstliches neuronales Netzwerk in der Größenordnung des menschlichen Gehirns vorstellen, das bei entsprechendem Training ähnliche Fähigkeiten haben könnte.

DPAM: Ist KI nur ein flüchtiger Trend?

Man schätzt, dass das menschliche Gehirn etwa 100 Milliarden Neuronen enthält, von denen jedes über Synapsen mit etwa 1.000 anderen Neuronen verbunden ist, insgesamt also über 100 Billionen Synapsen.

ChatGPT-4 soll etwa 1,8 Billionen Parameter („Synapsen“) haben. Das ist eine Verzehnfachung im Vergleich zu ChatGPT-3.5, das 175 Milliarden Parameter verwendet.

Führende KI-Forscher gehen davon aus, dass die Größe und Leistungsfähigkeit der Modelle weiter zunehmen wird. Ilya Sutskever, ehemaliger leitender Wissenschaftler bei OpenAI, geht sogar davon aus, dass die derzeitige KI-Architektur in Bezug auf die Fähigkeiten keine Grenzen kennt.

Die Anzahl der Parameter ist jedoch nicht der einzige Faktor, der die Leistung eines KI-Modells bestimmt. Fortschritte in der Modellarchitektur und der Zugang zu besseren, umfangreicheren Trainingsdaten können die Leistung erheblich steigern.

Dies zeigt sich in METAs neuestem Modell Llama 3, das trotz weniger Parameter beeindruckende Ergebnisse bei KI-Benchmarks erzielt. Vor allem während des Trainings von Llama 3 übertraf die Nutzung von mehr Trainingsdaten die Erwartungen an die Verbesserung des Modells.

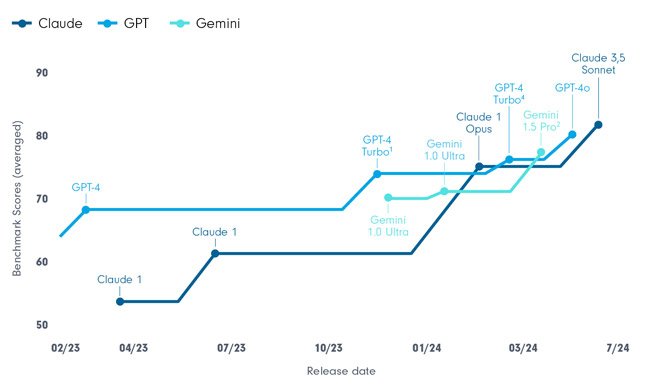

Zeitplan für das Release von AI-Modellen und Fähigkeiten

Quelle: Anthropic, 2024

Analog dazu ist die menschliche Intelligenz nicht festgelegt; mit mehr und besserem Training werden die Menschen intelligenter.

Sam Altman, CEO und Mitbegründer von OpenAI, sagt, dass es ein hohes Maß an wissenschaftlicher Gewissheit gibt, dass ChatGPT-5 viel intelligenter sein wird als ChatGPT-4, und ChatGPT-6 wird viel intelligenter sein als ChatGPT-5. Er betont, dass wir den Höhepunkt dieser Entwicklung noch lange nicht erreicht haben und über das Wissen verfügen, um weitere Fortschritte zu erzielen. ChatGPT-5 soll Gerüchten zufolge nach dem Sommer veröffentlicht werden.

Personalisierte Super-Assistenten werden die Produktivität für alle steigern

Die nächsten Durchbrüche bei den Fähigkeiten von KI-Modellen werden wahrscheinlich in längeren Kontextfenstern (d. h. der Länge der Eingabe), geringerer Latenz (d. h. der Geschwindigkeit der Antworten), billigeren Schlussfolgerungen (d. h. den Nutzungskosten des Modells), besserem Denken, besserer Planung und besserem Gedächtnis (d. h. das Modell erinnert sich an vergangene Interaktionen) liegen. Diese Fortschritte dürften den Weg für personalisierte virtuelle Super-Assistenten ebnen, die die Produktivität für alle steigern.

Bedeutung des Kontextfensters

Das derzeit führende KI-Modell in Bezug auf das Kontextfenster ist Googles Gemini 1.5, das über ein riesiges Kontextfenster mit 1 Million Token verfügt, was etwa einer Stunde Video, 11 Stunden Audio, 30.000 Zeilen Code oder 700.000 Wörtern (d. h. 8 Büchern) entspricht. Je größer das Kontextfenster ist, desto mehr Informationen kann das KI-Modell aus einer Eingabeaufforderung entnehmen, so dass seine Ausgabe nützlicher ist.

Das Konzept der neuronalen Netze ist nicht neu; tatsächlich gibt es sie schon seit fast einem Jahrhundert. Erst durch bemerkenswerte Fortschritte bei den Hardware-Fähigkeiten und die Verfügbarkeit riesiger Datenmengen konnten wir die massiven KI-Modelle trainieren, die wir heute sehen.

Training mit synthetischen Daten

Skeptiker weisen darauf hin, dass wir bei der Verfügbarkeit von Daten zur weiteren Verbesserung von KI-Modellen bald an Grenzen stoßen könnten. Es scheint jedoch, dass Daten kein begrenzender Faktor sein werden. KI-Modelle können Daten generieren, so genannte synthetische Daten, die dann zum Training anderer KI-Modelle verwendet werden können.

Multimodale KI-Modelle

Außerdem sind multimodale KI-Modelle auf dem Vormarsch, die nicht mehr nur auf Texteingaben angewiesen sind, sondern auch Bilder, Videos oder Audiodaten als Trainingsdaten verwenden können. Wie das Sprichwort sagt, sagt ein Bild mehr als tausend Worte; das Gleiche könnte auch für das Training von KI-Modellen gelten.

Teslas Humanoider Optimus

Quelle: Tesla, 2024

In der Tat kann praktisch alles „tokenisiert“ werden und als Input oder Output eines KI-Modells dienen: von Sprache und Video bis hin zu Bewegung und Sensorik. Dies ist von besonderer Bedeutung für Trainingsanwendungen wie selbstfahrende Autos oder humanoide Roboter, die dank der Nutzung von KI-Modellen rasche Fortschritte machen.

Innovative Prozessoren für Effizienzsteigerung in der Datenverarbeitung

Ein weiterer häufig gehörter Einwand ist, dass es immer schwieriger wird, Hardware-Fortschritte zu erzielen. Nvidia hat jedoch seine Vision für zukünftige KI-Rechenverbesserungen vorgestellt, die auf einem Ansatz auf Systemebene basiert. Bei diesem Ansatz beruhen Verbesserungen der Rechenkapazität nicht allein auf dem Mooreschen Gesetz - das sich auf die Erhöhung der Transistordichte von Chips konzentriert -, sondern vielmehr auf der Verbindung von Chips in einem Netzwerk, in dem sie als eine einheitliche Einheit funktionieren. Dieser innovative Systemansatz für die Rechenarchitektur eröffnet einen neuen Weg für kontinuierliche Effizienzsteigerungen in der Datenverarbeitung.

Die Zunahme der Modellgröße führt zu einer Projektion exponentiell steigender KI-Trainingskosten. Das Training von ChatGPT4 soll über 100 Millionen USD gekostet haben. Kürzlich haben OpenAI und Microsoft Pläne für ein 100 Mrd. USD teures Mega-KI-Rechenzentrum mit dem Namen Stargate vorgestellt.

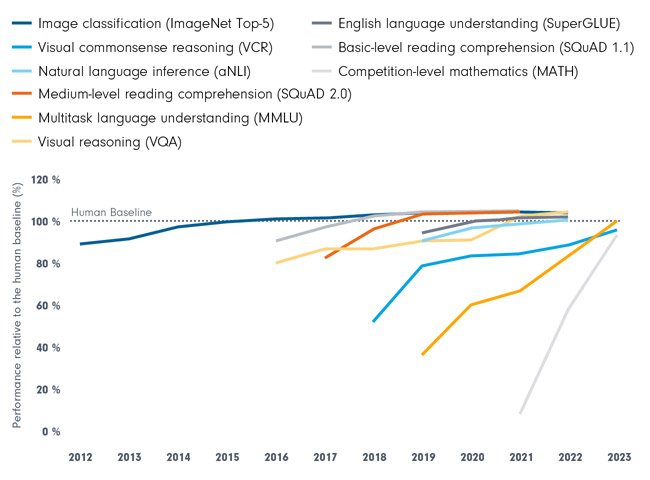

KI kann den Menschen nicht in allem schlagen... noch nicht

Quelle: Epoch, 2023, AI Index Report, 2024

Es ist sehr wahrscheinlich, dass die Intelligenz von KI-Modellen noch erheblich zunehmen wird. Während aktuelle KI-Anwendungsfälle bereits beeindruckende Produktivitätssteigerungen zeigen, kratzen wir wahrscheinlich nur an der Oberfläche ihres Potenzials. Wenn KI in der Lage ist, auf menschenähnliche Weise zu erstellen, zu denken und zu interagieren, hat sie das Potenzial, Aufgaben zu bewältigen, zu denen herkömmliche Software nie in der Lage war.

Erweiterte TAM als Rechtfertigung für eine massive Investitionswelle in die KI-Infrastruktur

Daher wäre es falsch, den gesamten adressierbaren Markt (TAM) der KI ausschließlich auf der Grundlage der derzeitigen Größe des Softwaremarktes zu bewerten, der sich auf etwa 600 Milliarden Euro beläuft. Ein geeigneterer TAM würde die aktuellen Dienstleistungs- und Fertigungsmärkte umfassen, die sich auf mehrere Billionen belaufen.

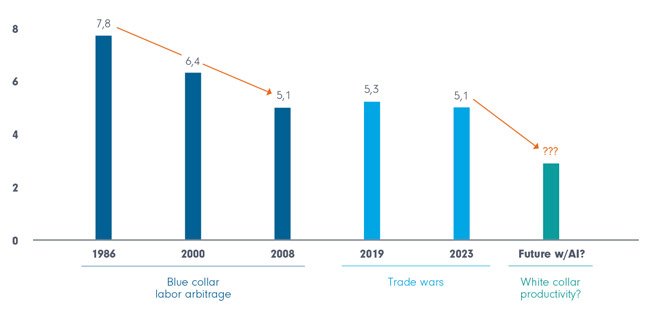

S&P500 Anzahl der Beschäftigten pro 1 Million USD Umsatz (inflationsbereinigt)

Quelle: Bloomberg, DPAM, 2024

Wenn es gelänge, auch nur einen kleinen Teil dieses riesigen TAM durch verringerte Betriebskosten (die zu produktiveren Arbeitskräften führen) oder die Schaffung neuer Einnahmequellen zu nutzen, wäre dies eine starke wirtschaftliche Rechtfertigung für eine massive Investitionswelle in die KI-Infrastruktur. Die Zukunft der KI ist vielversprechend und hat das Potenzial, Branchen zu revolutionieren und die Grenzen dessen, was Technologie leisten kann, neu zu definieren.

Autor

Dries Dury, Fondsmanager International Equities

Downloads für Ihre Beratung

Anlageprodukte:

DPAM L Equities Artificial Intelligence B EUR (LU2799769166)

Als Teil der Indosuez-Gruppe bietet DPAM aktive, nachhaltige Asset-Management-Dienstleistungen, die auf internem Research basieren. Die auf Überzeugungen gestützten Anlageentscheidungsprozesse von DPAM integrieren fundamentale Finanz- und ESG-Analysen. Fortschritt schafft Chancen - DPAM strebt eine langfristige Outperformance und ein Wachstum an, das sowohl den Anlegern als auch der Gesellschaft zugutekommt. Mit einem engagierten Team von mehr als 200 hochqualifizierten Fachleuten verwaltet DPAM Publikumsfonds sowie diskretionäre Mandate im Auftrag institutioneller und professioneller Kunden, Finanzintermediäre und Vertriebsgesellschaften mit einem Gesamtvolumen von 51,7 Milliarden Euro (Stand: 31. Dezember 2025).

Weitere Anlagestrategien:

Was verrät der jüngste Ausverkauf von Softwareaktien? | DPAM

Die Aktienmärkte fielen deutlich, insbesondere Softwarewerte. Trotz solider Z…

Die Kraft der Innovation | DPAM

Innovation treibt Gewinne, Gewinne treiben Aktienkurse. Diese Überzeugung ste…

Innovatives Investieren in einer konzentrierten Welt | DPAM

Die letzten 3 Jahre wurden von wenigen KI-Techunternehmen dominiert. Jetzt br…